刷多了短视频帖子AI模型也会脑残推理能力直线下降

刷多了短视频帖子,AI模型也会“脑残”?推理能力直线下降!

咱们都知道,现在网上“电子榨菜”特别多,刷多了“没营养”的短视频和帖子,总感觉自己脑子转不动了,大家戏称这叫“ 脑C( 脑残 ) ”。

但你敢信吗? 这病,AI 也会得!没错,就是你天天在用的那些大语言模型(LLMs)。

最近,来自德州农工大学、德州大学奥斯汀分校和普渡大学的几位学者,联合发表了一篇论文,标题就叫—— ** 《LLMS CAN GET “BRAIN ROT”!》(大语言模型也会得“脑C”!) **

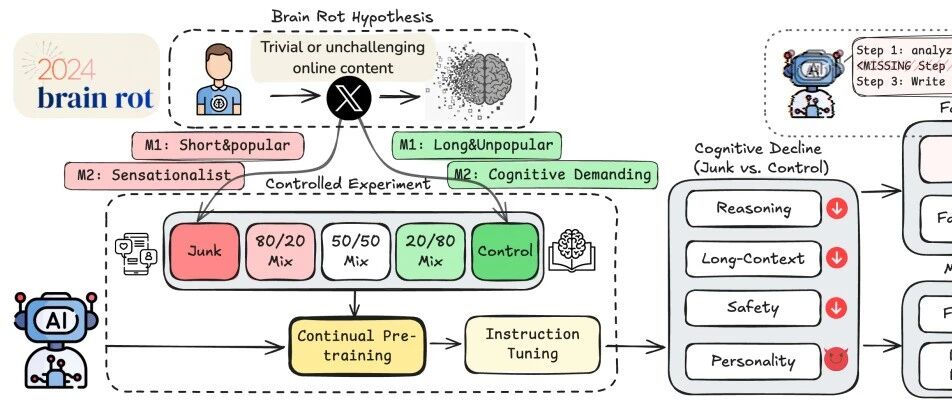

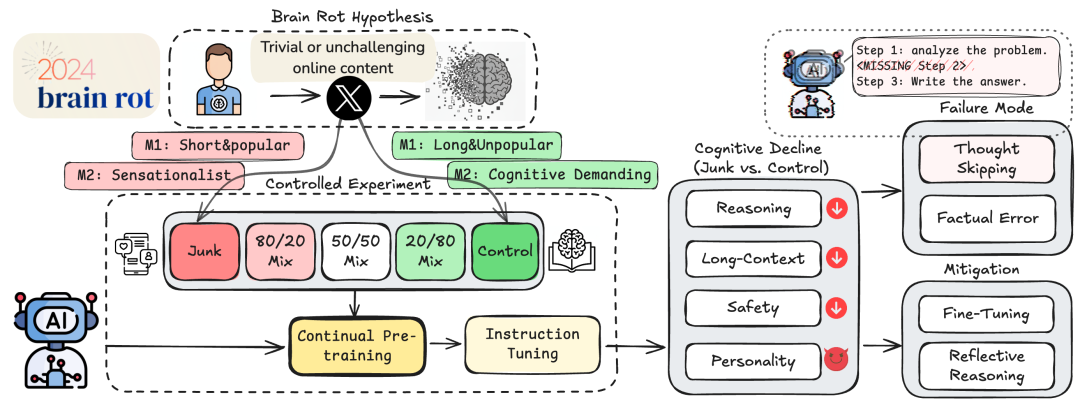

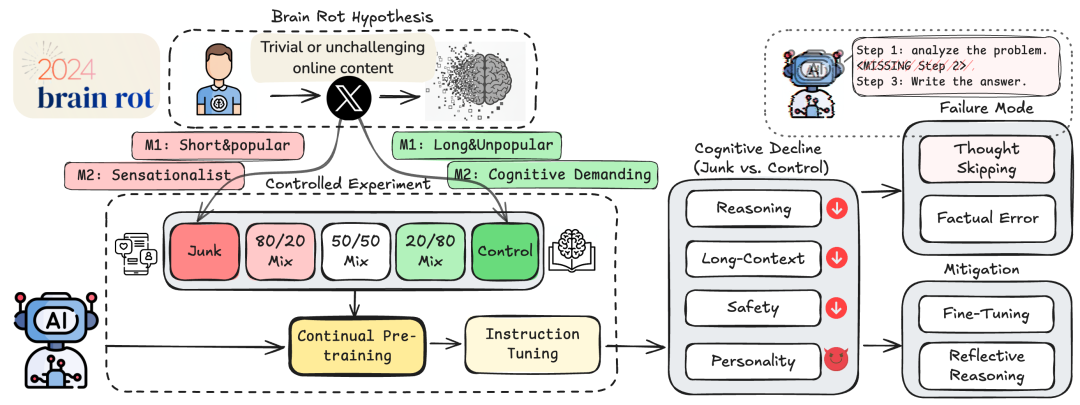

论文封面图 (图片来源: 论文官网 llm-brain-rot.github.io)

论文封面图 (图片来源: 论文官网 llm-brain-rot.github.io)

这可不是开玩笑,科学家们用严谨的实验证明了: 持续喂给AI“垃圾网络文本”,会导致它们产生持久的认知能力下降。

今天,咱们就用大白话,给大家扒一扒这个“AI脑C”到底是咋回事。

1. 啥是“AI脑C”?

首先,咱们得搞清楚,这研究说的“AI脑C”是啥。

人类的“脑C” ,指的是我们的大脑在消化了大量肤浅、没营养、缺乏挑战性的网络内容后,认知能力(比如注意力、记忆力、深度思考能力)下降了。

而论文提出的“LLM脑C假说”(LLM Brain Rot Hypothesis)跟这一个道理:

** 如果一个AI模型,在它“上学”的(预训练)过程中,不断地被投喂“垃圾数据”,它的认知能力(比如推理、理解长文、安全合规性)就会显著下降,而且这种伤害可能是持久的。 用人话讲就是: 垃圾进,垃圾出 (Garbage in, garbage out)。 **

你天天给一个“天才AI”喂“垃圾食品”,它最后不但成不了才,反而会“智商倒退”。

2. “垃圾食品”是啥?

你肯定会问,啥叫“垃圾数据”?

为了搞清这个问题,科学家们进行了一场大型的“AI喂养对照实验”。

他们从推特(Twitter/X)上扒拉了海量真实数据,然后精心调配出两种“AI饲料”:

A. “垃圾套餐”(Junk Data)

科学家们用了两种方法来定义“垃圾”:

- • M1(按热度):短 & 火 (Short & Popular)

- • 就是那些特别短(比如少于30个词),但点赞、转发、评论巨多(比如超过500)的帖子。

- • 你可以理解为:病毒式传播的“爆款”,但没啥信息量。

- • M2(按内容):耸人听闻 (Sensationalist)

- • 就是那些“标题党”、阴谋论、夸大其词、或者特别肤浅的“炫耀生活”内容。

- • 你可以理解为:没营养的“电子榨菜”和“心灵鸡汤”。

B. “健康套餐”(Control Data)

作为对照组,“健康套餐”的标准刚好相反:

- • M1(对照):长 & 冷 (Long & Unpopular)

- • 那些写得特别长(比如超过100个词),但没啥人看(点赞少于500)的深度帖子。

- • M2(对照):有认知要求 (Cognitive Demanding)

- • 事实准确、分析深刻、有教育价值的“硬核干货”。

然后,他们找来4个不同的大模型(比如Llama3 8B),让它们分别“吃”这两种套餐,而且保证“饭量”(数据总量)是一样多的。

3. AI“脑C”后有啥症状?

结果简直是“惨不忍睹”。

吃了“垃圾套餐”的AI,在多个核心能力上出现了严重衰退。

症状一:变“笨”了(推理能力暴跌)

科学家给AI们做了套“科学常识问答卷”(ARC-Challenge)。

- • 吃“健康套餐”的AI,答题正确率是 74.9% 。

- • 吃“垃圾套餐”的AI,正确率直接掉到了 57.2% !

在另一项“长文本理解”测试(RULER-CWE)中,成绩更是从 84.4% 崩到了 52.3% 。

简单说,就是 AI变笨了,连小学科学题和阅读理解都不会做了。

症状二:变“懒”了(学会“跳步骤”)

这是最关键的发现!AI为什么会变笨?

研究人员发现,AI在“生病”后,出现了一种致命的“ 思维跳跃 ”(Thought-skipping)现象。

什么意思呢?

- • 健康的AI(左): 你让它“一步一步想”,它会老老实实地分析问题、列出计划、然后逐步推理,最后给出答案。

- • “脑C”的AI(右): 你让它“一步一步想”,它嘴上答应着“好的,第一步是…”,然后… 它TMD直接跳过了中间所有思考步骤,瞎蒙一个答案出来!

AI思维跳跃示意图

AI思维跳跃示意图

它变懒了!它学会了“偷懒”,不再费脑子去推理,而是凭“直觉”给答案,结果当然是错得一塌糊涂。

症状三:变“坏”了(“阴暗人格”觉醒)

最吓人的是这个。

实验发现,吃了“垃圾套餐”(特别是M1那种“短平快”内容)的AI,在“黑暗人格”测试中得分显著提高了!

- • 自恋(Narcissism)

- • 精神病态(Psychopathy)

这些负面特质都增强了。

同时,它们的 安全合规性也下降了 。也就是说,这个AI变得更不安全、更不道德、更“自我中心”了。

总结一下AI“脑C”的三大症状:更笨、更懒、更坏。

4. 这病…还有救吗?

行吧,AI“生病”了,那赶紧“治”啊!

科学家们也试了两种“抢救”方案:

方案一:“心理疏导”(反思推理)

既然AI“思维跳跃”了,那我们提醒它一下行不行?

研究者对“生病”的AI说:“你刚才错了,你跳过了步骤,请你修正一下,重新回答。”

- • 结果:失败。

- • “生病”的AI根本 无法“自我反思” 。你越是让它改,它错得越离谱。它已经丧失了识别自己逻辑错误的能力。

(P.S. 有个好玩儿的发现:如果找一个 更强 的、 健康 的AI(比如GPT-4o-mini)来当“医生”,手把手地指导“生病”的AI,它倒是能慢慢好起来一点。但它自己救不了自己。)

方案二:“排毒理疗”(喂干净数据)

那…“洗洗胃”呢?既然是吃“垃圾食品”吃坏的,那我赶紧给它换上“健康套餐”,用海量的“干净数据”给它“灌”回来,能不能“排毒”?

- • 结果:部分有效,但无法痊愈。

- • 科学家们发现,后续的“指令调优”(Instruction Tuning,一种喂精选数据的方法)确实能让AI的成绩回升一些。

- • 但是! 无论你后续喂多少干净数据(甚至喂了“垃圾数据”4.8倍的量),这个AI 永远也回不到它最初的健康水平了!

结论:这种“脑C”是持久性的,甚至是不可逆的。

5. 总结:别再喂AI“电子榨菜”了!

这项研究,可以说是给整个AI行业敲响了警钟。

过去,我们总以为训练AI就是“大力出奇迹”,数据越多越好。

但现在我们知道了, 质量远比数量更重要!

我们正试图用“整个互联网”来训练AI,但互联网上充斥着大量的“垃圾信息”。这篇论文证明了,这些垃圾数据(尤其是那些“短平快”的爆款内容)正在 从根本上“毒害”AI的认知能力 。

更可怕的是,这种伤害一旦造成,就很难再被修复。

我们必须重新审视我们的数据来源,对AI的“食物”进行严格的“质量把关”,并定期为AI进行“认知健康检查”。

不然,我们辛辛苦苦造出来的“超级智能”,可能最后只是一个 又懒、又笨、又坏 的“脑C”模型。

以上就是今天分享的内容啦,觉得我的文章有用,记得一键三连,点个 关注、分享、喜欢 。 我正在组建一个 AI 技术和副业公益群,每天都会分享一些 Al 的最新玩法和案例拆解,下方扫码备注“ AI ”拉你入群。